Bonjour à tous,

Pour faire suite au tutoriel du safesearch ICI et à l'intervention de LeBretonLibre, Je vous propose de voir une forme de proxy qu’on trouve couramment dans les entreprises : le proxy-cache puis ensuite de filtrer les requêtes HTTP afin de protéger les enfants.

———————

SOMMAIRE

A. Introduction

B. Installez le proxy-cache Squid

C. Configurer le proxy-cache Squid

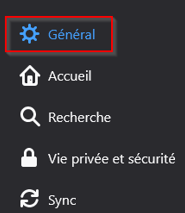

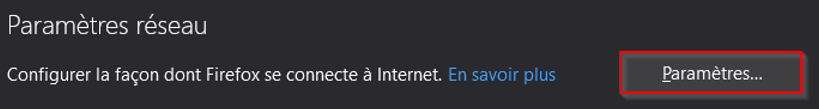

D. Paramétrez Firefox

E. Contrôle d'accès horaires

F. Authentification des utilisateurs

G. Installer SquidGuard

H. Configurer SquidGuard

I. Reconfiguration du fichier squid.conf

J. Mettre en place une tache planifiée pour la mise à jour de la blacklist

K. Conclusion

L. Sources[

———————

A. Introduction

- Il y a différentes formes de serveurs de cache possible. Le type de serveur cache que vous verrez ici se place sur le réseau des clients, en intermédiaire avec des

sites internet distants. Ainsi, si tous les utilisateurs d’un même réseau local passent par un proxy-cache, lorsque le premier utilisateur va télécharger des fichiers sur Internet, ils seront stockés sur le proxy-cache. Si un deuxième utilisateur demande les mêmes fichiers, ils seront pris dans le proxy-cache sauf si entre-temps ils ont été modifiés sur le site distant. L’utilisation d’un proxy-cache peut donc permettre un accès plus rapide aux utilisateurs et un gain de bande passante au niveau de la connexion Internet.

- Un autre intérêt d’un cache local est qu’il peut autoriser ou d’interdire l’accès à certains ressources en ligne : sites web, ports/services, etc. Il est alors possible de mettre en place une politique de sécurité globale pour tout un réseau local.

- Il y a plusieurs façons d’utiliser un proxy-cache :

-

son utilisation peut être optionnelle et l’accès direct à Internet peut être possible également (si on n’est intéressé que par le côté performance par exemple)

-

son utilisation peut être obligatoire et explicite : le seul moyen d’accéder à Internet est alors de passer à travers le proxy-cache mais les utilisateurs doivent configurer manuellement leur navigateur (ou autre application) pour utiliser ce proxy-cache.

-

son utilisation peut être obligatoire et implicite: le seul moyen d’accéder à Internet est de passer à travers le proxy-cache mais les utilisateurs n’ont pas besoin de configurer leur navigateur, leur connexion passe par le proxy-cache de manière transparente

- En France et dans beaucoup de pays, il y a une obligation légale d’informer les utilisateurs de la collecte et de l’utilisation de leurs données qui pourraient être faites

dans le cadre de la mise en place d’un proxy-cache. Dans une entreprise, les utilisateurs peuvent par exemple être amenés à signer une charte de bon usage du réseau qui précise les données collectées par le proxy et l’usage qui est fait de ces données.

- Pour mettre en place ce proxy-cache, je vous propose d’utiliser le logiciel Squid.

- Le fait de mettre en place un proxy sur un serveur dédié distant ou en local chez vous a pour bénéfice d’outrepasser les bridages/censures, que peut mettre en

place un FAI. De plus, ici l’idée est d’essayer d’éviter au mieux, que des enfants surfant sur la toile tombent sur du contenu non recommandé. Évidemment, aucune protection ne peut égaler l’accompagnement d’un parent sur les risques, qu’on peut rencontrer en naviguant sur le web.

- Pour ajouter une couche de filtrage, vous pouvez utilisez votre propre serveur DNS (unbound, pieHole) configuré sur les serveurs DNS d’OpenDNS family shield (voir le tuto précédent ICI)

- Pour Pi-Hole, DX90 à fait un tuto disponible ICI.

- Pour le filtrage, j’ai choisi SquidGuard, j’aurais pu choisir DansGuardian car il est beaucoup plus performant lors de l’analyse des requêtes, mais il prend beaucoup de ressources matériels ou bien faire du filtrage directement avec Squid (ce ne sera pas traité dans ce tutoriel.)

- Un petit comparatif entre SquidGuard et DansGuardian:

-

+ DansGuardian: vrai filtrage de contenu sur toute la page et sur l’URL.

-

+ SquidGuard :facile à mettre en place et plutôt léger en utilisation CPU/RAM.

-

– DansGuardian: demande énormément de ressource CPU/RAM.

-

– SquidGuard: filtrage par domaines.

INFO: Toutes les commandes dans le tuto sont éxécutées en tant que root.

———————

B. Installez le proxy-cache Squid

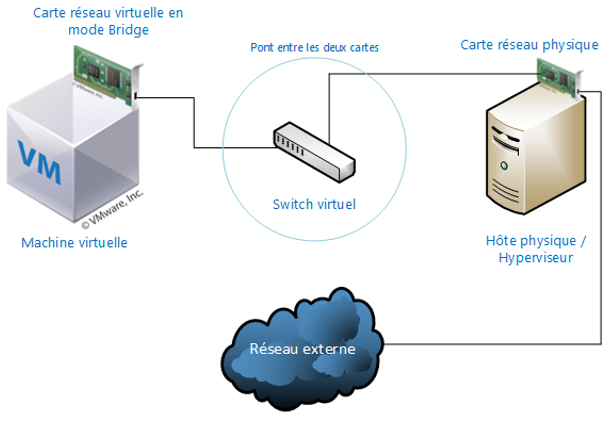

- J'ai utilisé une VM en mode Bridge via le logiciel VMware Workstation et une distribution Debian. Ce mode est surement le plus utilisé puisqu’il permet de connecter une machine virtuelle directement sur le réseau physique sur lequel est branchée la carte réseau physique de l’hôte.

- Pour cela, un bridge c'est-à-dire un pont est créé entre la carte réseau virtuelle de l’application de virtualisation et la carte réseau de votre hôte physique. C’est en quelque sorte un partage de carte réseau, où le système d’exploitation de votre hôte physique partage sa carte physique avec le système d’exploitation de votre ou vos machines virtuelles.

- Si votre hôte physique dispose de plusieurs cartes réseaux,vous pouvez choisir de créer un pont avec celle que vous souhaitez, ce qui permet une flexibilité dans la configuration et dans la gestion de la connexion réseau.

- Vu que la machine virtuelle se retrouvera connectée sur le même réseau que la machine physique, il lui faudra une configuration TCP/IP identique aux autres postes du réseau afin qu’elle puisse communiquer avec le reste du réseau et sortir du réseau.

- Nous installerons les outils invités VMware à l'aide desoutils Open VM Tools. Open VM tools est l'implémentation open source de VMwareTools. Il est spécialement conçu pour les distributions Linux et il est disponible dans les référentiels standard de la plupart des distributions Linux. Nous allons donc l'installer depuis le gestionnaire de paquets Debian.

- Il est beaucoup plus facile à installer que l'installation d'outils VMware standard. Pour démarrer l'installation, lancez le terminal dans votre système d'exploitation Debian et entrez la commande ci-dessous pour installer à l'aide du gestionnaire de paquets apt:

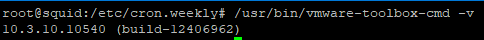

apt-get install open-vm-tools- Pour voir la version :

/usr/bin/vmware-toolbox-cmd -v

- Connectez-vous avec le compte super-utilisateur (root) :

su -- Ouvrez le fichier /etc/apt/sources.list avec l’éditeur de texte nano ou vi :

nano /etc/apt/sources.list- Vérifiez que le fichier soit comme ceci. Ajout des composants contrib et non-free pour obtenir les paquets non libres et le dépôt Backports pour des paquets plus récents :

#

# deb cdrom:[Debian GNU/Linux 10.3.0 _Buster_ -Official amd64 NETINST 20200208-12:07]/ buster main

#deb cdrom:[Debian GNU/Linux 10.3.0 _Buster_ -Official amd64 NETINST 20200208-12:07]/ buster main

deb http://deb.debian.org/debian/ buster main contrib non-free

deb-src http://deb.debian.org/debian/ buster main contrib non-free

deb http://security.debian.org/debian-securitybuster/updates main contrib non-free

deb-src http://security.debian.org/debian-securitybuster/updates main contrib non-free

# buster-updates, previously known as 'volatile'

deb http://deb.debian.org/debian/ buster-updates maincontrib non-free

deb-src http://deb.debian.org/debian/ buster-updatesmain contrib non-free

# This system was installed using small removablemedia

# (e.g. netinst, live or single CD). The matching"deb cdrom"

# entries were disabled at the end of the installationprocess.

# For information about how to configure apt packagesources,

# see the sources.list(5) manual.

# Backports

deb http://deb.debian.org/debian buster-backports maincontrib non-free- Sauvegardez avec Ctrl+ O > Entrée,puis quittez avec Ctrl + X.

- Vérifiez que votre connexion Internet est opérationnelle :

ping 8.8.8.8 -c 4

PING 8.8.8.8 (8.8.8.8) 56(84) bytes of data.

64 bytes from 8.8.8.8: icmp_seq=1 ttl=54 time=27.9 ms

64 bytes from 8.8.8.8: icmp_seq=2 ttl=54 time=28.3 ms

64 bytes from 8.8.8.8: icmp_seq=3 ttl=54 time=28.1 ms

64 bytes from 8.8.8.8: icmp_seq=4 ttl=54 time=27.7 ms

--- 8.8.8.8 ping statistics ---

4 packets transmitted, 4 received, 0% packet loss,time 8ms

rtt min/avg/max/mdev = 27.690/28.011/28.295/0.305 ms - Mettez à jour la liste des paquets et la distribution :

apt-get update && apt-get full-upgrade -> VotreDebian est maintenant à jour !

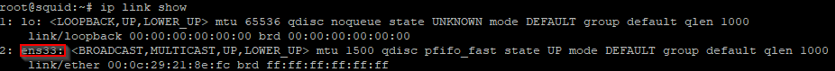

- On va attribuer une adresse IP fixe au serveur. Vérifier le nom (ici ens33) de la connexion avec :

ip link show

- Editez le fichier /etc/network/interfaces :

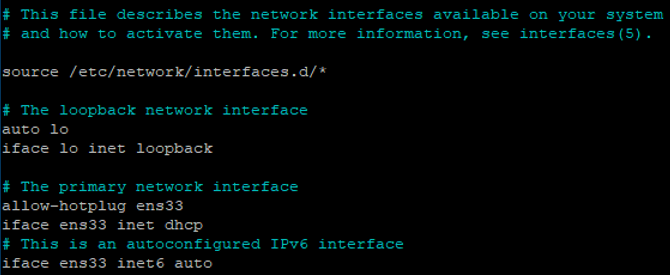

nano /etc/network/interfaces- Pour du DHCP, il ressemble à ceci :

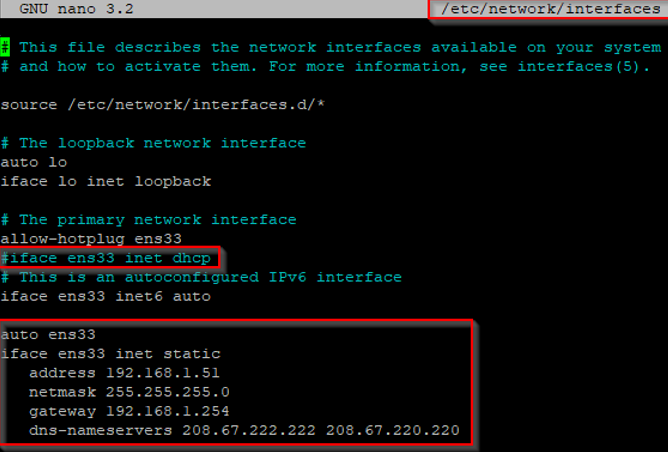

- Éditez le fichier pour de l'adresse IP fixe (A adapter selon votre réseau local) :

auto [b]ens33[/b]

iface ens33 inet static

address192.168.1.51

netmask255.255.255.0

gateway192.168.1.254

dns-nameservers 208.67.222.222 208.67.220.220- Commentez la ligne iface ens33 inet dhcp, Il doit maintenant ressembler à cela :

- On redémarre le réseau,

systemctl restart networking- Si cela ne marche pas, on reboot:

systemctl reboot- Si cela ne marche toujours pas, on vérifie l'état de l'interface soit up via :

ip link show- Si ce n'est pas le cas, on l'active (A adapter):

ifup ens33———————

C. Configurer le proxy-cache Squid

- Toute la configuration se fait ensuite dans lefichier /etc/squid/squid.conf

- Dans ce fichier, toutes les lignes commençant par # sont des commentaires.

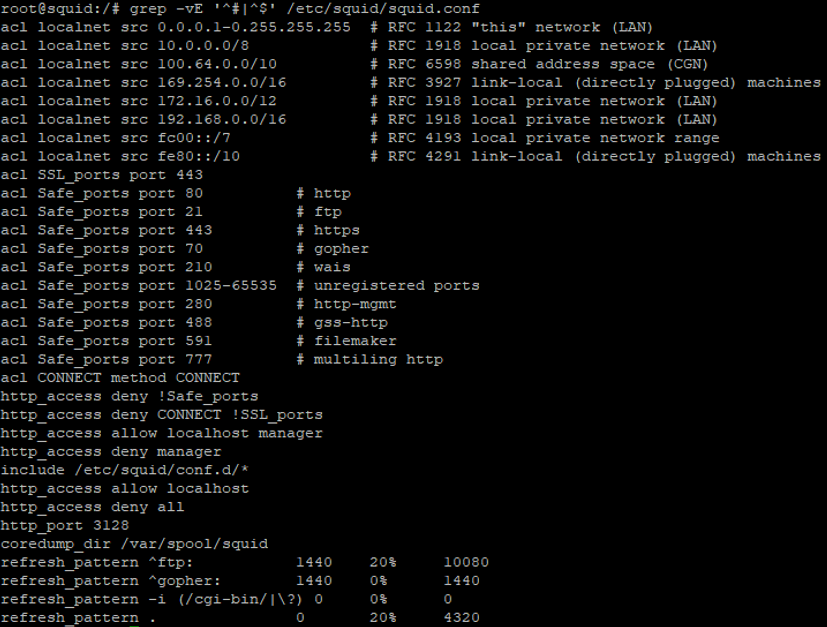

- Vous pouvez voir le contenu de ce fichier débarrassé des commentaires et des lignes vides par la commande :

grep -vE ‘^#|^$’ /etc/squid/squid.conf

- Dans ce fichier de configuration, toutes les lignes commencent par une directive.

- Ici vous voyez acl, http_access, http_port, coredump et refresh_pattern et il en existe bien d’autres!

- La directive http_port indique l’adresse et le port sur lesquels écoute Squid. Par défaut, Squid écoute sur toutes les interfaces réseau sur le port 3128.

- Vous pouvez configurer plusieurs directives http_port pour que Squid écoute sur plusieurs adresses ou ports.

- La directive coredump_dir indique le répertoire dans lequel Squid peut écrire des fichiers core qui sont des fichiers d’erreur.

- Les directives refresh_pattern précisent les règles qui établissent si un fichier est “frais” ou “périmé”. Un fichier “périmé” est supprimé du cache. Vous pouvez laisser les règles par défaut.

- Les directives les plus importantes à connaître sont acl et http_access. ACL signifie Access ControlList. Les ACL sont donc des critères de contrôle d’accès qui seront ensuite utilisés par la directive http_access pour autoriser ou interdire les connexions HTTP en fonction de ces critères.

- Concernant la directive acl :

-

Le 2e champ représente le nom de l’acl. Plusieurs directives acl avec le même nom vont cumuler les critères de chaque directive.

-

Le 3e champ indique le type d’acl. Il existe de nombreux types mais les plus importants sont src (source), dst (destination), port et time (temps).

-

Le 4e champ indique la valeur. En fonction du type, cette valeur pourra être l’adresse d’un réseau, un port, etc.

- Dans la configuration par défaut, vous pouvez voir qu’une ACL Safe_ports est définie. Elle regroupe un ensemble de portsTCP courants et considérés comme sûrs auxquels vous pourrez donner accès à vos utilisateurs.

- La directive http_access est suivie de allow ou deny pour autoriser ou interdire l’accès au proxy-cache.

- Le dernier champ est le nom de l’ACL qui va être évaluée pour autoriser ou interdire l’accès.

Le nom de l’ACL peut être précédé d’un ! pour indiquer “le contraire”de l’ACL. Par exemple, par défaut, la première directive http_access est :

http_access deny !Safe_ports

-> Elle signifie “Accès interdit à tous les ports sauf les ports définis dans l’ACL Safe_ports”.

- Les directives http_access sont lues dans l’ordre et sont exécutées dès qu’une règle correspond. Il est donc recommandé de toujours terminer par :

http_access deny all

pour interdire l’accès si aucune autre règle ne correspond.

- Dans les règles par défaut, vous pouvez voir les règles suivantes :

-

http_access allow localhost manager

-

http_access deny manager

qui n’autorisent l’accès à une règle “manager” qu’en local. Squid est fourni avec un Cache Managerqui est une interface web de gestion du cache. Vous pouvez y accéder en ligne de commande avec l’outil squidclient. Pour avoir un aperçu, installez le paquet squidclient et lancez la commande squidclient mgr:info

- Maintenant que vous connaissez les principales directives de Squid, vous allez pouvoir créer vos propres règles

———————

- Commencez par sauvegarder le fichier squid.conf à titre de référence :

cd /etc/squid && cp squid.conf squid.conf.defaults - Le fichier de configuration de Squid comportant plus de 5000 lignes, autant vous dire que nous n'allons pas tout afficher.

- On va donc créer un fichier de configuration sans les lignes commentées pour une meilleure visualisation.

- Pour cela, on tape les commandes suivantes :

cat /etc/squid/squid.conf.defaults | grep -v ^# |grep -v ^$ > /etc/squid/squid.conf-> La dernière commande permet de prendre toutes les lignes non-commentées du fichier squid.conf.defaults et les met dans le fichier squid.conf

- Le fichier ressemble à cela :

acl localnet src 0.0.0.1-0.255.255.255 # RFC 1122 "this" network (LAN)

acl localnet src 10.0.0.0/8 # RFC 1918 local private network (LAN)

acl localnet src 100.64.0.0/10 # RFC 6598 shared address space (CGN)

acl localnet src 169.254.0.0/16 # RFC 3927 link-local (directly plugged) machines

acl localnet src 172.16.0.0/12 # RFC 1918 local private network (LAN)

acl localnet src 192.168.0.0/16 # RFC 1918 local private network (LAN)

acl localnet src fc00::/7 # RFC 4193 local private network range

acl localnet src fe80::/10 # RFC 4291 link-local (directly plugged) machines

acl SSL_ports port 443

acl Safe_ports port 80 # http

acl Safe_ports port 21 # ftp

acl Safe_ports port 443 # https

acl Safe_ports port 70 # gopher

acl Safe_ports port 210 # wais

acl Safe_ports port 1025-65535 # unregistered ports

acl Safe_ports port 280 # http-mgmt

acl Safe_ports port 488 # gss-http

acl Safe_ports port 591 # filemaker

acl Safe_ports port 777 # multiling http

acl CONNECT method CONNECT

http_access deny !Safe_ports

http_access deny CONNECT !SSL_ports

http_access allow localhost manager

http_access deny managerinclude /etc/squid/conf.d/*

http_access allow localhost

http_access deny all

http_port 3128

coredump_dir /var/spool/squid

refresh_pattern ^ftp: 1440 20% 10080

refresh_pattern ^gopher: 1440 0% 1440

refresh_pattern -i (/cgi-bin/|?) 0 0% 0

refresh_pattern . 0 20% 4320- On définit notre réseau local:

acl lan src 192.168.1.0/24 - On autorise notre réseau local appelé "lan"

http_access allow lan - Masquer notre adresse IP dans le header HTTP (X-Forwarded-For: unknown)

forwarded_for off- Log d’erreur en français :

error_directory /usr/share/squid/errors/French - Rejet de tous les ports différents de ceux déclarés dans les acls

http_access deny !Safe_ports- Empêcher les personnes extérieures au réseau de passer par le proxy :

http_access deny all- On rajoute ensuite les 2 lignes suivantes à la fin du fichier :

cache_effective_user proxy cache_effective_group proxy

cache_mem 256 MB

cache_dir ufs /var/spool/squid/squid 120 16 128 -> Les dernières lignes signifie que l'on crée un répertoire de mémoire cache situé dans /var/spool/squid. Ce répertoire est de type ufs, sa taille maximum est de 120Mo. Dans ce répertoire il y a 16 répertoire de niveau 1 qui contiennent chacun 128 répertoire de niveau 2.

- Voilà à quoi ressemble mon fichier final commenté :

#Directives d'accès

acl localnet src 0.0.0.1-0.255.255.255 # RFC 1122 "this" network (LAN)

acl localnet src 10.0.0.0/8 # RFC 1918 local private network(LAN)

acl localnet src 100.64.0.0/10 # RFC 6598 shared address space (CGN)

acl localnet src 169.254.0.0/16 # RFC 3927 link-local (directlyplugged) machines

acl localnet src 172.16.0.0/12 # RFC 1918 local private network(LAN)

acl localnet src 192.168.0.0/16 # RFC 1918 local private network (LAN)

acl localnet src fc00::/7 # RFC 4193 local private network range

acl localnet src fe80::/10 # RFC 4291 link-local (directlyplugged) machines

#On définit notre réseau local

acl lan src 192.168.1.0/24

#acl par défaut

acl SSL_ports port 443

acl Safe_ports port 80 # http

acl Safe_ports port 21 # ftp

acl Safe_ports port 443 # https

acl Safe_ports port 70 # gopher

acl Safe_ports port 210 # wais

acl Safe_ports port 1025-65535 # unregistered ports

acl Safe_ports port 280 # http-mgmt

acl Safe_ports port 488 # gss-http

acl Safe_ports port 591 # filemaker

acl Safe_ports port 777 # multiling http

acl CONNECT method CONNECT

#On autorise notre réseau local appelé "lan"

http_access allow lan

#Rejet de tous les ports différents de ceux déclarés dans les acls

http_access deny !Safe_ports

http_access deny CONNECT !SSL_ports

#Autorise l’accès au cachemanager via squidclient qu’en local

http_access allow localhost manager

http_access deny manager

#On autorise tous les fichiers externe de configuration par défaut

include /etc/squid/conf.d/*

#On autorise le réseau local

http_access allow localhost

#interdire l’accès si aucune autre règle ne correspond.

#Empêche les personnes extérieures au réseau de passerpar le proxy

http_access deny all

#On écoute pas sur l’interface publique du serveur

http_port 192.168.1.51:3128

#Masquer notre adresse IP dans le header HTTP(X-Forwarded-For: unknown)

forwarded_for off

#Log d’erreur en français :

error_directory /usr/share/squid/errors/French

#Répertoire des fichiers d'erreurs "core"

coredump_dir /var/spool/squid

#Précisent les règles qui établissent si un fichier est “frais” ou “périmé”. Un fichier “périmé” est supprimé du cache

refresh_pattern ^ftp: 1440 20% 10080

refresh_pattern ^gopher: 1440 0% 1440

refresh_pattern -i (/cgi-bin/|?) 0 0% 0

refresh_pattern . 0 20% 4320

#Creation du répertoire de mémoire cache

cache_effective_user proxy cache_effective_group proxy

cache_mem 256 MB

cache_dir ufs /var/spool/squid/squid 120 16 128- On relance maintenant Squid avec la commande :

systemctl restart squid———————

D. Paramétrer Firefox

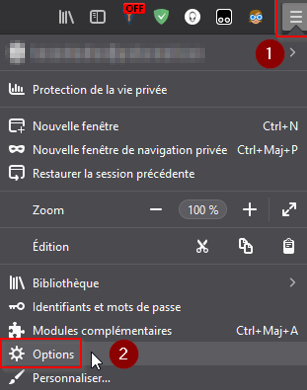

- Paramétrons le proxy dans le navigateur Firefox :

- Fermer firefox et le relancer puis tester l’accès à un site, cela devrait fonctionner.

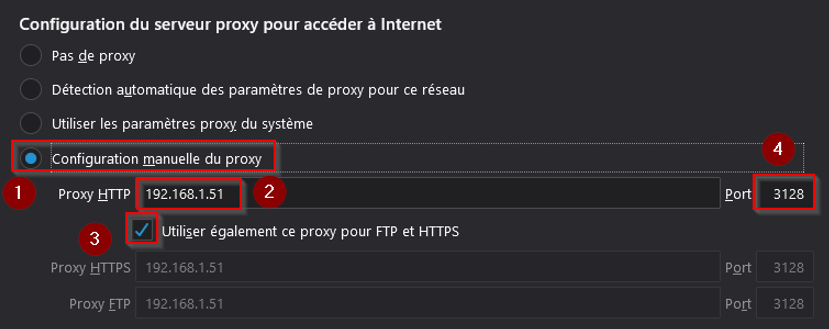

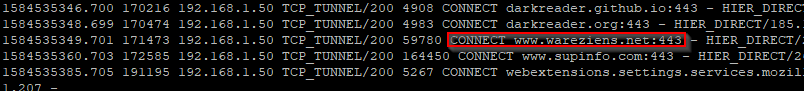

- En regardant le fichier access.log du serveur, nous pouvons observer que l'accès a été autorisé:

cat /var/log/squid/access.log

———————

E. Contrôle d'accès horaires

- Squid permet de restreindre l'accès de certains postes clients suivant des plages horaires.

- On ajoute alors les lignes suivantes dans le fichier de configuration de Squid :

#Définit les hôtes autorisés:

acl allowed_hosts src 192.168.1.50

#Définition de la plage horaire sur laquelle les postes sont autorisés:

acl limithour time 12:00-15:00

#Autorise l'accès http aux hôtes qui ont une plage horaire d'accès:

http_access allow-allowed_hosts limithour - On teste alors sur le client et on observe que l'accès est bien restreint. C'est à dire que l'on peut accéder seulement de 12:00 à 15:00.

———————

F. Authentification des utilisateurs

- Dans cette partie, on va montrer comment s'authentifier avec Squid.

- On utiliseras Openssl pour crer le fichier de password de la manière suivante :

printf "USERNAME:$(openssl passwd -crypt PASSWORD)n" | tee -a /etc/squid/squidusers- Créons l’utilisateur milou avec le password milou :

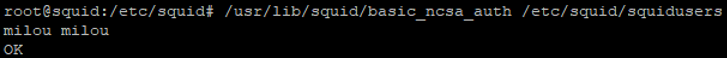

printf "milou:$(openssl passwd -crypt 'milou')n" | tee -a /etc/squid/squidusers- Pour vérifier que le fichier est correct et fonctionnera avec Squid, utilisez la commande suivante :

/usr/lib/squid/basic_ncsa_auth /etc/squid/squidusers - Rentrez votre login et votre mot de passe de la manière suivante :

<login> <mot de passe>-

Si la réponse est OK, tout est bon

-

Si la réponse est ERR, vérifiez votre fichier users

- Pour sortir de la boucle appuyez sur ctrl + D.

- On modifie ensuite le fichier de configuration de Squid en rajoutant les lignes suivantes :

Avant la partie acl on ajoute les directives auth:

auth_param basic program /usr/lib/squid/basic_ncsa_auth /etc/squid/[b]squidusers[/b]

auth_param basic children 5

auth_param basic realm Squid proxy-caching web server

auth_param basic credentialsttl 2 hours[b][/b]-

children : 5 est une valeur usuelle. Si vous avez denombreux utilisateurs, il sera peut-être nécessaire d'augmenter ce nombre.

-

realm : texte qui apparaîtra dans la fenêtre de demanded'identification.

-

credentialsttl : durée de vie de l'identification.

- Ensuite, à la fin de la partie acl on rajoute la directive acl nommée auth pour autoriser les utilisateurs à se connecter :

acl auth proxy_auth REQUIRED - Ensuite on rajoute en 1er (important sinon l’authentification ne sera pas demandée) dans les directives http_access la directive pour pouvoir s’authentifier :

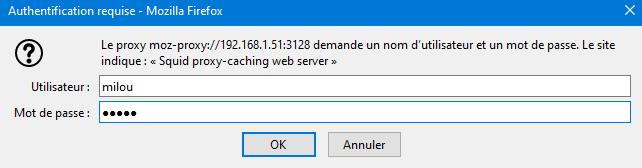

http_access allow auth - On relance ensuite le service squid afin de vérifier que l'authentification mise en place fonctionne correctement.

systemctl restart squid- Firefox vous demandera une authentification au proxy :

———————

G. Installer SquidGuard

- On installe SquidGuard via la commande suivante:

apt install squidguard———————

H. Configurer SquidGuard

- SquidGuard est un logiciel complémentaire à Squid qui permet de gérer le filtrage avec des bases de données qu’il a créé à partir d’une blacklist.

- Téléchargement de la blacklist de l’université de Toulouse :

cd /tmp

wget http://dsi.ut-capitole.fr/blacklists/download/blacklists.tar.gz- Extraction du fichier :

tar -xzf blacklists.tar.gz- Copie du dossier Blacklist dans le répertoire de squidguard :

cp -R blacklists/* /var/lib/squidguard/db/- Faire une copie du fichier de configuration de SquidGuard :

cp /etc/squidguard/squidGuard.conf /etc/squidguard/squidGuard.default- Modification de SquidGuard :

nano /etc/squidguard/squidGuard.conf- Seule la machine de l'admin pourra aller n'importe où :

src admin {

ip 192.168.1.50

}- Nous allons ensuite déterminer les catégories qu’on interdit (A adapter,se référer aux fichiers de l’archive Blacklist):

# les règles de filtrage

dest adult {

domainlist adult/domains

urllist adult/urls

expressionlist adult/very_restrictive_expression

}

dest porn {

domainlist porn/domains

urllist porn/urls

expressionlist porn/very_restrictive_expression

}

dest publicite {

domainlist publicite/domains

urllist publicite/urls

}

dest aggressive {

domainlist aggressive/domains

urllist aggressive/urls

}

dest social_networks {

domainlist social_networks/domains

urllist social_networks/urls

}

dest phishing {

domainlist phishing/domains

urllist phishing/urls

}

dest malware {

domainlist malware/domains

urllist malware/urls

}- Nous créons nos ACL qui autorisera ou interdira selon ce qu’on a déclaré précédemment :

acl {

admin {

pass any

}

default {

pass !adult !porn !publicite !aggressive !social_networks !phishing !malware all

redirect https://www.zupimages.net/up/20/12/x0j2.jpg

}

}-> Le ! devant adult, porn , adult, publicite, aggressive, social_networks, phishing, malware signifie interdit.

Si un utilisateur du réseau tombe sur un site interdit, le dit site sera bloqué et redirigé vers une page souhaitée

INFO: Je crois qu'il est impossible de rediriger du traffic HTTPS via cette méthode, si quelqu'un à une solution, je suis preneur bien évidemment

- Voila à quoi ressemble mon fichier final débarrassé de tout commentaires:

dbhome /var/lib/squidguard/db

logdir /var/log/squidguard

src admin {

ip 192.168.1.101

}

dest adult {

domainlist adult/domains

urllist adult/urls

expressionlist adult/very_restrictive_expression

}

dest porn {

domainlist porn/domains

urllist porn/urls

expressionlist porn/very_restrictive_expression

}

dest publicite {

domainlist publicite/domains

urllist publicite/urls

}

dest aggressive {

domainlist aggressive/domains

urllist aggressive/urls

}

dest social_networks {

domainlist social_networks/domains

urllist social_networks/urls

}

dest phishing {

domainlist phishing/domains

urllist phishing/urls

}

dest malware {

domainlist malware/domains

urllist malware/urls

}

acl {

admin {

pass any

}

default {

pass !adult !porn !publicite !aggressive !social_networks !phishing !malware all

redirect https://www.zupimages.net/up/20/12/x0j2.jpg

}

}- Création d’un lien symbolique du fichier de configuration squidGuard.conf dans /etc/squid/ :

ln -s /etc/squidguard/squidGuard.conf /etc/squid/- Application des droits nécéssaires :

chown -R proxy:proxy /var/log/squid

chown -R proxy:proxy /var/lib/squidguard- On ouvre dans un premier temps les logs dans un second terminal avec la commande

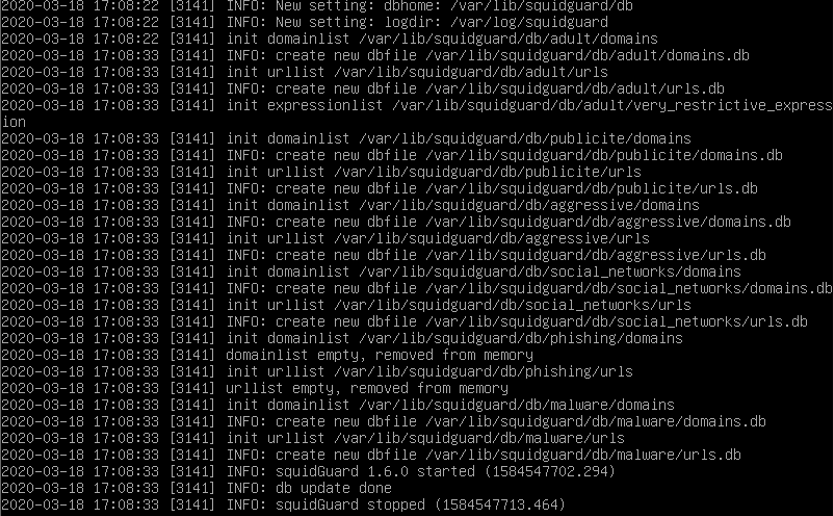

tail -f/var/log/squidguard/squidguard.log- Puis on génère la base de données des blacklists configurées en regardant les logs

squidGuard -C all-> Cela peut prendre du temps selon le nombre de catégories que vous voulez bloquer, ou si il y a un problème mais nous pouvons voire cela dans les logs.

- Nous voyons que tous s’est bien passé:

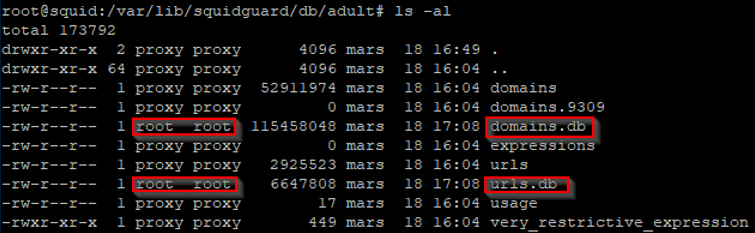

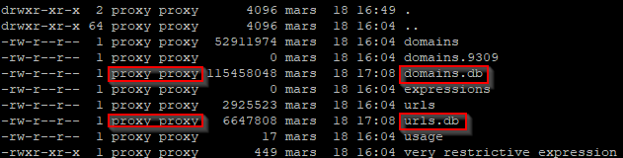

- On a donc générer dans chaque répertoire de catégories bloquées, un fichier domain.db et un urls.db. SquidGuard les a généré en tant que root, il faut

donc changer le propriétaire pour que l’utilisateur proxy ai le droit d’y accéder:

ls -al /var/lib/squidguard/db/adult

chown -R proxy:proxy /var/lib/squidguard

- Ajout de mot interdit (A adapter selon les blacklist) :

nano /var/lib/squidguard/db/adult/very_restrictive_expression- Et ajouter des mots entre pipes « | »

- Regénérer labase après modifications :

squidGuard -C all———————

I. Reconfiguration du fichier squid.conf

- Maintenant, il faut indiquer à Squid d'intégrer SquidGuard pour qu'il puisse traiter et filtrer les requetes HTTP.

- Intégration du module de SquidGuard dans Squid:

url_rewrite_program /usr/bin/squidGuard -c/etc/squid3/squidGuard.conf

url_rewrite_children 10

- On recharge la configuration et on redémarre le service:

systemctl reload squid

systemctl restart squid

———————

J. Mettre en place une tache planifiée pour la mise à jour de la blacklist

- Créer un script bash:

cd /tmp

nano updateblacklist#!/bin/bash

cd /tmp

wget http://dsi.ut-capitole.fr/blacklists/download/blacklists.tar.gz

tar -xzf blacklists.tar.gz

cp -rf blacklists/* /var/lib/squidguard/db/

rm -Rf blacklists*

squidGuard -C all

systemctl squid restart- Rendre le script éxécutable :

chmod +x updateblacklist- Ajouter le script dans cron.weekly :

mv updateblacklist /etc/cron.weekly/———————

K. Conclusion

- Une fois tout cela réalisé avec un peu d’effort pour la mise en place, on a donc un serveur proxy fonctionnel apportant un contrôle d'accès efficace pour les utilisateurs et assez souple pour pouvoir l'adapter facilement en fonction des besoins.

- On peut être débarrassé de certains contenus sur la toile MAIS ce n’est pas 100% fiable. Je pense, qu’il faut tout de même expliquer aux enfants, qu’ils peuvent tomber sur du « mauvais » contenu et dans ce cas prévenir un adulte ou tout simplement fermer la page en question.

———————

L. Sources

https://memo-linux.com/installer-un-pro … us-debian/

https://ngiraud.net/index.php/2019/02/1 … ard-proxy/

https://www.supinfo.com/articles/single … roxy-squid

https://doc.ubuntu-fr.org/tutoriel/comm … ation_ncsa

https://kifarunix.com/how-to-setup-squi … -password/

http://irp.nain-t.net/doku.php/220squid:060_squidguard